Interview: Mit Bits & Bytes gegen Demenz

Neue Ansätze für die Vorbeugung und Therapie der Alzheimer-Erkrankung könnten sich aus der Analyse von Gendaten ergeben. Doch deren Auswertung bedarf enormer Rechenpower. Vor diesem Hintergrund untersucht das DZNE gemeinsam mit dem IT-Unternehmen Hewlett Packard Enterprise (HPE) die Potenziale das „Memory-Driven Computing“. Das DZNE ist weltweit das erste Institut, das diese Technologie in der biomedizinischen Forschung einsetzt. Sie beruht auf Computern neuartiger Architektur — entwickelt von HPE im Rahmen seines „The Machine“-Forschungsprogramms: Anders als bei herkömmlichen Rechnern steht nicht der Prozessor im Mittelpunkt, sondern der Speicher. Ein Interview mit Prof. Joachim Schultze, Genomforscher und Arbeitsgruppenleiter am DZNE, über das Projekt und seine Perspektiven.

Herr Schultze, was verspricht sich die Alzheimer-Forschung von der Analyse von Gendaten?

Alzheimer ist eine komplexe Erkrankung. So kennt man zwar einige Mutationen, die Alzheimer auslösen, bei der überwiegenden Mehrzahl der Krankheitsfälle scheinen jedoch diverse Faktoren zusammenspielen. Darin liegt die Komplexität. Alzheimer ist wie ein großes Puzzle. Die Aufgabe lautet also, dessen Bausteine zu finden und zusammenzusetzen. So scheint der Lebensstil eine Rolle zu spielen, aber auch die Gene tragen mehr oder weniger dazu bei, ob man erkrankt oder gesund bleibt. Es gibt Genkonstellationen, die das Erkrankungsrisiko steigern — die Erkrankung aber nicht zwangsläufig auslösen. Andere Genvarianten hingegen schützen offenbar vor Alzheimer. Menschen mit derlei Erbanlagen erkranken statistisch gesehen seltener. Vonseiten der Genforschung versuchen wir, solche Risiko- bzw. Schutzfaktoren aufzuspüren.

Was bringt das?

Einerseits hoffen wir, die Ursachen und Mechanismen von Alzheimer besser zu verstehen. Das ist Grundlagenforschung — und potentiell Grundlage für neue Therapien. Anderseits könnte auch die Prävention, also die Krankheitsvorsorge davon profitieren.

Wieso?

Es wäre denkbar, mithilfe der Erbanlagen ein persönliches Risikoprofil zu erstellen. Immer vorausgesetzt, Betroffene sind dazu bereit. Natürlich macht dies erst dann Sinn und ist ethisch vertretbar, wenn die therapeutischen Möglichkeiten besser sind als heute – wenn also Maßnahmen zur Verfügung stehen, die das Krankheitsrisiko verringern. Das ist derzeit noch Zukunftsmusik, aber durchaus ein realistisches Anliegen.

Geht es dabei um Medikamente?

Wir wissen noch nicht, wie eine effektive Prävention bei Alzheimer aussieht. Ein Baustein davon könnten Medikamente sein, die den Ausbruch der Erkrankung zumindest hinauszögern, wenn sie die Erkrankung schon nicht verhindern können. In die Vorsorge können aber auch andere Faktoren eingehen. Zum Beispiel der Lebensstil. Untersuchungen legen nahe, dass Menschen, die regelmäßig Sport treiben und auf ihr Herz-Kreis-Lauf-System achten, ihrem Gehirn Gutes tun und dass sie weniger anfällig sind für Alzheimer. Aus diesen Befunden lassen sich bislang aber nur allgemeine Empfehlungen ableiten, was den Lebensstil angeht. Hier hat man die Hoffnung, dass man eines Tages konkreter werden und Empfehlungen geben kann, die auf die jeweilige Person und deren Risikoprofil individuell zugeschnitten sind. Das wäre ein Beitrag zu einer personalisierten Krankheitsprävention.

Wie werden denn Schutz- beziehungsweise Risikogene aufgespürt?

Man sucht in den Erbanlagen nach auffälligen Mustern. Dafür muss man die Genome von möglichst vielen gesunden Personen und möglichst vielen Alzheimer-Patienten miteinander vergleichen. Häufen sich bei Patienten bestimmte Genvarianten, so ist das ein Indiz, wenn auch noch kein Beweis, dass diese Erbanlagen für die Erkrankung von Bedeutung seien könnten. Um herauszufinden, ob es tatsächlich einen ursächlichen Zusammenhang gibt, muss man dieser Spur weiter nachgehen. Man schaut sich zum Beispiel an, welche Proteine von den betroffenen Genen kodiert werden und wie diese Proteine am Stoffwechsel beziehungsweise der Funktion von Nervenzellen oder Immunzellen im Gehirn beteiligt sind. Das abzuklären, ist durchaus nicht trivial. Insofern liefert die Genanalyse zwar wichtige Hinweise, sie ist aber nur ein Ansatzpunkt.

Welche Datenmengen werden dabei verarbeitet?

Das menschliche Genom umfasst rund drei Milliarden Bausteine. Für jeden Baustein gibt es vier Möglichkeiten, das entspricht einer Datentiefe von zwei Bit. In digitaler Übersetzung umfasst das Genom also etwa 700 Megabytes. Allerdings sind die Datensätze, die von Gensequenzierern erzeugt werden, in der Regel viel größer. Pro Genom umfassen sie typischerweise etwa 180 Gigabytes. Das liegt daran, dass in solchen Datensätzen das Genom zumindest teilweise mehrfach enthalten ist. Die Erbanlagen werden von einem Sequenzierer ja quasi gelesen und durchbuchstabiert. Das geschieht nicht in einem Rutsch. Vielmehr erfasst der Sequenzierer nach und nach überlappende Abschnitte des Genoms, die später zusammengefügt werden müssen. Außerdem enthalten solche Datensätze nicht nur die Gensequenz, sondern beispielsweise auch Informationen zur Datenqualität. So kommt man letztlich auf ein Datenvolumen von etwa 180 Gigabytes pro Genom. Das ist Speicherplatz für mehr als 35 Standard-DVDs.

Benötigt man für Studien das gesamte Genom?

Nicht zwangsläufig. Für manche Fragestellung kann man auch Ausschnitte des Genoms verwenden. Was man aber auf jeden Fall benötigt, sind Gendaten möglichst vieler Personen. Idealerweise von einigen tausend. Das summiert sich dann zu Datenmengen in der Größenordnung von einigen hundert Terabyte.

Wie lange rechnen gängige Computer daran?

Das kann schon einige Tage oder Wochen dauern. Denn für jeden einzelnen Verarbeitungsschritt müssen immer wieder riesige Datenmengen von externen Speichermedien, das sind im Wesentlichen Festplatten, in den im Vergleich dazu kleinen Arbeitsspeicher des Computers geladen werden. Das kostet Zeit. Die Hauptbremse bei Genanalysen ist also weniger das Rechentempo des Prozessors, auch wenn man hier allmählich an Grenzen stößt. Denn es gibt immer schnellere Prozessoren. Die Hauptbremse ist vielmehr der Zugriff auf die Daten. Das ist wie bei einem Puzzlespiel. Sind die Puzzleteile auf viele Schachteln verteilt, die man erst nacheinander öffnen muss, um nach passenden Teilen zu suchen, dann dauert das lange. Wesentlich schneller geht es, wenn alle Teile ausgebreitet auf dem Tisch liegen. Auf Computer übersetzt heißt das: Man benötigt einen großen Arbeitsspeicher, in dem idealerweise sämtliche Daten vorliegen, so dass der Prozessor direkt auf sie zugreifen kann. Das ist die Kernidee des Memory-Driven Computing.

Wie setzt das DZNE diese Technologie ein?

Derzeit arbeiten wir daran, die Algorithmen der Genanalyse der neuen Rechner-Architektur anzupassen. Hier müssen wir also zunächst Entwicklungsarbeiten leisten. Dabei muss man sich deutlich machen, dass die Analyse von Gendaten in mehreren Prozessschritten geschieht. Für jeden dieser Schritte werden passende Algorithmen benötigt. Wir haben uns deshalb einen ganz entscheidenden Prozessschritt angeschaut. Diesen Prozessschritt gilt es zu bewältigen, um mit der Datenauswertung überhaupt beginnen zu können. Er steht am Anfang der Analyse und ist ziemlich rechenintensiv. Vereinfacht gesprochen geht es darum, die Genschnipsel, die von einem Sequenzierer erzeugt werden, zu einer durchgehenden Sequenz zusammenzusetzen. Wir wollten herausfinden, wie weit sich dieser Vorgang beschleunigen lässt. Dazu haben wir einen bewährten Algorithmus genommen und den Besonderheiten des Memory-Driven Computing angepasst. Fazit: Wir konnten die Rechenzeit für einen kleinen Testdatensatz von ursprünglich 22 Minuten auf 13 Sekunden verkürzen. Das heißt, wir sind etwa hundertmal schneller geworden. Wichtig dabei ist es, dass die Beschleunigung auch für viel größere Datenmengen, so wie sie bei großen Populationsstudien auftreten, erhalten bleibt. Wir sprechen davon, dass die Vorteile der neuen Rechnerarchitektur skalieren.

Welche Rechner werden verwendet?

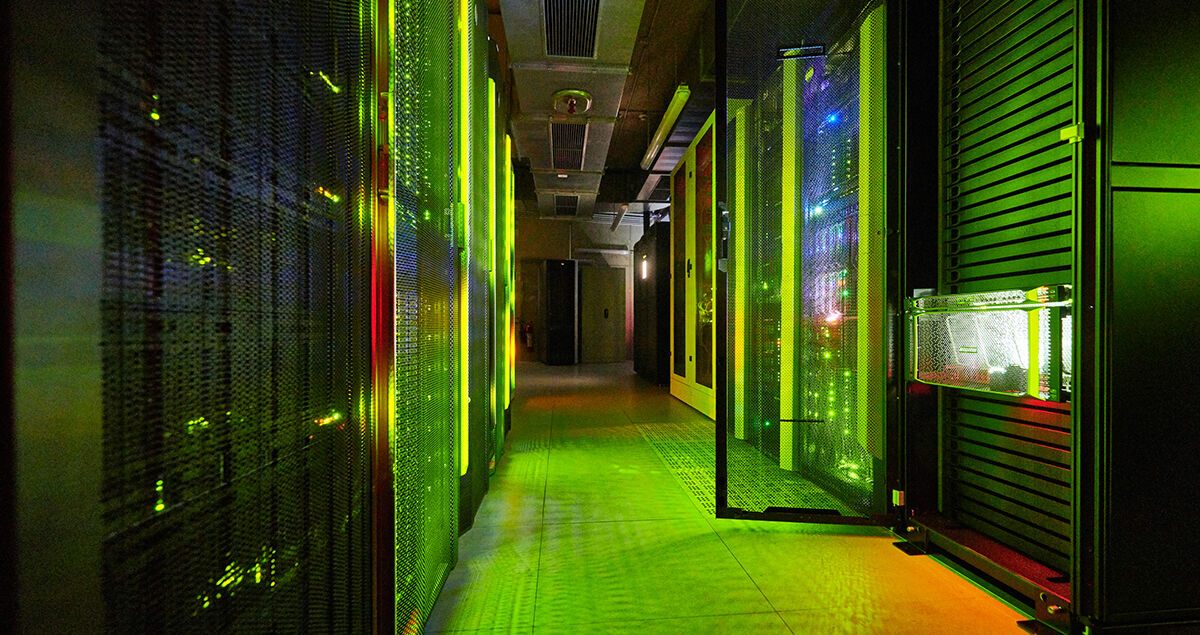

Bislang gibt es von HPE einen Prototypen, der konsequent auf Memory-Driven Computing ausgelegt ist. Der steht in den USA und hat den größten Arbeitsspeicher weltweit, 160 Terabyte. Auf dieser Maschine haben wir bisher einen Testlauf durchgeführt. Hier waren wir die ersten Kooperationspartner von HPE weltweit, denen dies ermöglicht wurde. Ansonsten rechnen wir auch auf Computern von HPE, mit denen sich das Verhalten des Prototypen mit Hilfe von Software nachahmen lässt. Hier spricht man von einer Emulation. Die ist zwar nicht so schnell, wie das Rechnen auf dem Prototypen. Dennoch kann man wesentliche Aspekte nachbilden. Seit kurzem haben wir in unserem Bonner Rechenzentrum auch einen eigenen Computer für solche Tests. Es handelt sich um eine „HPE Superdome Flex“. In dessen Hardware sind zumindest einige Prinzipien des Memory-Driven Computing bereits verwirklicht. Insbesondere ist der Rechner auf extrem schnellen Datenaustausch ausgelegt und er verfügt über einen Arbeitsspeicher von 1,5 Terabyte, der sich auf bis zu 48 Terabyte erweitern ließe.

Wie geht es weiter?

Bislang haben wir uns im Wesentlichen auf einen Algorithmus konzentriert. Für die Genanalyse benötigt man aber noch weitere Software-Werkzeuge. Diese wollen wir nach und nach dem Memory-Driven Computing anpassen. Stehen die Werkzeuge bereit, wollen wir mit der Auswertung aktueller Forschungsdaten beginnen. Ich denke, bis Mitte 2019 könnten wir soweit sein, dass wir mit solchen Analysen loslegen können. Und die Entwicklung wird weitergehen. Unser Fernziel ist, Gendaten von Tausenden von Personen innerhalb weniger Minuten miteinander zu vergleichen.

Und danach?

Ich gehe davon aus, dass diese neue Technologie die Forschung maßgeblich beeinflussen, ja verändern wird. Sie wird es ermöglichen, Informationen in einem Umfang zusammenzubringen und auszuwerten, wie es bislang kaum denkbar war. Und dabei geht es nicht nur um Gendaten. Speziell am DZNE werden von der Grundlagenforschung bis zur klinischen Forschung und der Populationsforschung enorme Datenmengen generiert. Wir haben das Ziel, diese Informationsstränge zu verknüpfen. Ich erwähnte, ja schon: Alzheimer ist wie ein großes Puzzle. Wenn man sich nur einzelne Teile anschaut, verliert man den Überblick. Doch genau dieses Gesamtbild wollen wir uns verschaffen. Man kann sich zum Beispiel fragen, in welcher Weise sich krankheitsrelevante Genvarianten auf das Gehirn auswirken. Naheliegend wäre es daher, Gendaten mit Daten von Hirnuntersuchungen zu verknüpfen — zum Beispiel mit Hirnscans, die per Magnetresonanztomographie gemessen wurden. Dieses Konzept kann man natürlich noch weiter denken und Laborwerte und weitere Ergebnisse aus klinischen Studien einbeziehen. Und das für hunderte oder gar tausende von Untersuchungspersonen. Das ist wirklich Big Data. Um solche Datenmengen auszuwerten, benötigen wir passende Werkzeuge. Deshalb setzen wir große Hoffnung in diese neue Computertechnik.

Das Interview führte Marcus Neitzert.